« L’envers des mots » : Agnotologie

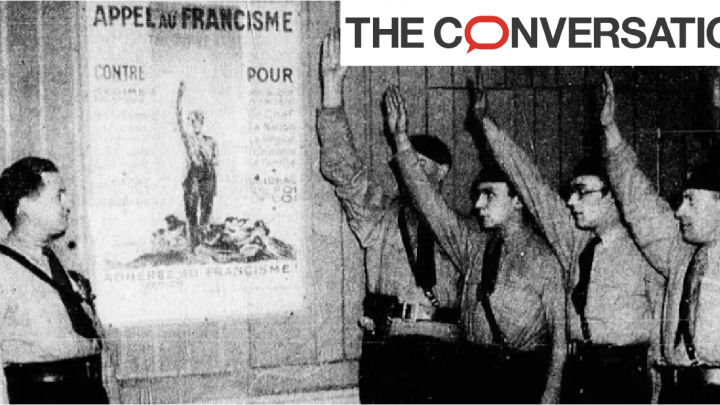

Publié le 25 juin 2023 « L’envers des mots » : Agnotologie Marie Meyer, Université de Haute-Alsace (UHA) et Dominique Kern, Université de Haute-Alsace (UHA) Les sciences occidentales ont peu appréhendé la question de l’ignorance malgré le fait que, selon les mots de Karl Popper, « notre connaissance ne peut être que finie, tandis que notre ignorance est nécessairement infinie », avec d’importantes conséquences sur nos vies. C’est ce qu’observe Robert N. Proctor en introduction d’un ouvrage collectif sur l’agnotologie publié en 2008. Cet historien des sciences de l’Université de Stanford a œuvré à combler cette lacune. Il propose alors le terme « agnotologie », du grec agnôsis (« ne pas savoir »), qui renvoie à l’étude de l’ignorance et de sa « production ». Ce concept profite alors d’un intérêt croissant dans les sciences humaines et sociales et certains auteurs évoquent même une véritable science de l’ignorance, permettant de théoriser la rupture avec les certitudes et la production de savoirs inconnus. Cette ignorance peut avoir différentes origines. Tout d’abord, il y a des facteurs dont le chercheur n’a pas connaissance, même vis-à-vis de sa propre thématique de recherche. Ensuite, ces mêmes facteurs peuvent ne pas avoir été, ou ne pas être, exploités au cours du processus et des faits scientifiques peuvent tout à fait être ignorés comme ajoutés a posteriori. Enfin, il est important de souligner que toutes les méthodes de recherche présentent leurs propres limites. De ce fait, les études et même les productions validées peuvent parfois faire l’objet de réévaluations ultérieures et être réinterrogées par les spécialistes. À l’inverse, il se peut qu’un chercheur travaille toute sa carrière sur une même thématique pour, finalement, remettre l’ensemble de ses réflexions en question ou ouvrir ses travaux sur des zones inexpliquées, voire inexplicables. Dès lors, il s’agit du savoir qui « est rendu inutilisable et ne peut plus servir de prémisse à des décisions ou à d’autres enquêtes ». Du point de vue scientifique, pour le chercheur l’agnotologie constitue un exercice difficile et peu répandu : il est plus complexe pour un spécialiste de présenter et de décrire ce qu’il ignore que de traiter d’un savoir qu’il maîtrise. Paradoxalement, cette science se matérialise régulièrement et sous différentes formes dans le domaine de la recherche avec de nouveaux savoirs qui sont produits et qui viennent se substituer aux plus anciens ou encore de nouveaux écrits scientifiques qui viennent remettre en question, voir rendre obsolètes, leurs prédécesseurs. Ainsi, l’incorporation de ce concept dans une réflexion permet d’apporter un regard nouveau sur les connaissances produites ou analysées dans une recherche scientifique, pareil à une « antiépistémologie ». Là où l’épistémologie permet de réaffirmer ou encore de construire de nouveaux savoirs, l’antiépistémologie « demande comment la connaissance peut être recouverte et obscurcie », questionnement nécessaire dans toute théorisation et/ou production de savoirs savants. Mais l’ignorance analyse les connaissances dans une double dimension : qu’est-ce que nous ne savons pas ? Pourquoi n’avons-nous pas accès à ces connaissances ? Ce doute et la remise en question des connaissances générés par l’agnotologie permettent de (re) lancer les dialogues et de modifier des comportements. En effet, si pour le chercheur inclure l’agnotologie revient à interroger les zones d’ombres de son travail, ce qui relève donc d’une approche « honnête » à l’égard de ses réflexions et productions, cette démarche se retrouve également au quotidien. Un exemple parlant est celui de la désinformation. En plus des sources possibles d’agnotologie, citées précédemment, il se peut que l’absence d’information soit intentionnelle. Cette rétention de connaissance se retrouve d’ailleurs dans plusieurs domaines comme, par exemple, l’industrie du tabac. De nombreuses compagnies ont financé des études dans le but de prouver l’influence d’autres facteurs que celui de la cigarette sur la santé des individus. Il ne s’agit donc pas ouvertement d’un mensonge mais bien de recherches permettant de détourner l’attention avec l’idée d’influencer la population : on parle alors d’ignorance stratégique. De plus, la désinformation s’est modifiée avec le développement des réseaux sociaux où chaque individu peut librement partager ses connaissances ou idées sur les thématiques de son choix. Mathias Girel évoque alors plusieurs termes permettant de nuancer les situations rencontrées sur ces plates-formes entre la « mésinformation », pour évoquer les fausses informations non intentionnelles et la « malinformation » pour les fausses informations ayant pour objectif de nuire volontairement à autrui. Dans tous les cas, l’agnotologie rappelle la nécessité de conserver une attitude critique et une posture d’acteur vis-à-vis des informations qui nous parviennent. La première étape reste de vérifier les sources, dont la légitimité de l’auteur à traiter de la thématique abordée. Également, l’ignorance omniprésente, en raison des différentes modalités que nous avons évoquées, permet de garder à l’esprit que des zones d’ombres demeurent dans les échanges que nous entretenons au cours d’une journée ainsi que dans les travaux de recherche auxquels nous pouvons nous intéresser. Cet article s’intègre dans la série « L’envers des mots », consacrée à la façon dont notre vocabulaire s’étoffe, s’adapte à mesure que des questions de société émergent et que de nouveaux défis s’imposent aux sciences et technologies. Des termes qu’on croyait déjà bien connaître s’enrichissent de significations inédites, des mots récemment créés entrent dans le dictionnaire. D’où viennent-ils ? En quoi nous permettent-ils de bien saisir les nuances d’un monde qui se transforme ? Marie Meyer, Doctorante en Sciences de l’éducation et de la formation, Université de Haute-Alsace (UHA) et Dominique Kern, Professeur des Universités, PhD Sciences de l’éducation et de la formation, Université de Haute-Alsace (UHA) Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original. Marie Meyer Doctorante en sciences de l’éducation et de la formation (LISEC) Dominique Kern Professeur des Universités en sciences de l’éducation et de la formation (FLSH & LISEC) Sur le même thème Tous |Article |Non classé |Podcast |Question |Recherche participative |Vidéo Pour un enseignement de qualité des langues à l’université (3) 17 février 2016/ Publié le 17 février 2016 Pour un enseignement de qualité des langues à l’université (3) Marielle Silhouette, Université Paris Nanterre – Université Paris Lumières;… Article Avis de Recherche N°4 – 150 ans de la Société Française de Physique 8 novembre 2023/ Publié le 8 novembre 2023 Avis…