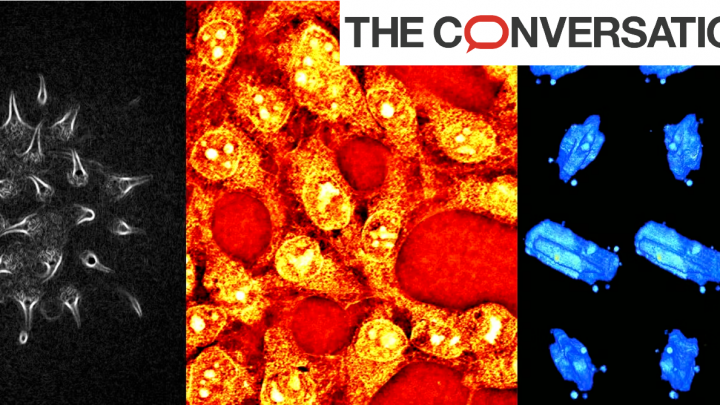

Publié le 5 avril 2023 Vers un microscope optique universel « tout-en-un » ? Olivier Haeberlé, Université de Haute-Alsace (UHA); Matthieu Debailleul, Université de Haute-Alsace (UHA) et Nicolas Verrier, Université de Haute-Alsace (UHA) Le microscope optique est un outil clé de la recherche depuis le XVIe siècle, qui a permis d’innombrables découvertes en biologie (comme l’existence des cellules ou l’identification des premiers microbes). D’abord très rudimentaire, cet instrument a donné lieu à une intense émulation pour le perfectionner, et on cherche toujours encore à en améliorer les performances. Une technique suscite actuellement un intérêt croissant, la « microscopie tomographique diffractive », sur laquelle nous travaillons, et qui pourrait mener au développement d’un outil « tout-en-un », permettant même de visualiser directement en 3D des spécimens microscopiques. En termes de résolution, c’est-à-dire la capacité à distinguer de très petits détails, le microscope atteint un plafond dès la fin du XIXe siècle. C’est une surprise pour les fabricants de microscopes, bloqués dans leurs développements. Ernst Abbe y apportera une explication éclatante, avec sa loi définissant la résolution : En histoire des sciences, c’est un cas intéressant où la technologie a atteint les limites théoriques d’un système, avant même que celles-ci ne soient clairement établies par la physique. Chaque technique de microscopie présente ses limites Ceci explique que les recherches ont alors plutôt visé à corriger les défauts ou optimiser certains paramètres, par exemple supprimer les distorsions dans les images, agrandir le champ de vue, et surtout, augmenter le contraste. La technique la plus simple est l’utilisation de colorants, mais ceux-ci sont toxiques pour les spécimens biologiques, interdisant les études sur le vivant. La microscopie de fluorescence, au succès extraordinaire, est un cas à part, et ses spécificités ont même permis la réalisation de nanoscopes optiques à la résolution inégalée, qui permettent de visualiser l’architecture des cellules jusqu’à l’échelle moléculaire. Mais cette technique présente aussi des limites (obligation de marquage, phototoxicité induite). Ainsi, de nombreuses techniques pour visualiser, sans marquage, des spécimens translucides ont aussi été inventées, une des plus efficaces et esthétiques visuellement étant la microscopie à contraste de phase différentiel, qui fait apparaître des pseudo-reliefs, c’est-à-dire que les niveaux de gris visibles sont interprétés par le cerveau comme un relief, alors que le spécimen ne présente en fait pas de relief topographique. Ces différentes techniques se caractérisent par une certaine maîtrise des conditions d’illumination et/ou de détection de la lumière interagissant avec le spécimen. Elles sont parfaitement adaptées pour, par exemple, détecter la présence de bactéries dans l’eau, effectuer des mesures morphologiques, ou observer l’évolution temporelle de phénomènes comme la division cellulaire. Mais les images obtenues souffrent de restrictions qui en limitent encore l’exploitation : la résolution reste limitée à environ 200 nanomètres en pratique. Si la nanoscopie optique 3D est une réalité en fluorescence, sans marquage, elle représente toujours un rêve pour l’utilisateur, et un défi pour le physicien ; les contrastes observés restent qualitatifs, et ne peuvent être reliés à des grandeurs physiques autres que dimensionnelles. C’est une des grosses limitations de ces techniques qui enregistrent des images en intensité uniquement : on peut par exemple facilement mesurer des tailles, ou observer des changements de formes, qui sont des données dimensionnelles, mais les niveaux d’intensité observés ne sont pas directement reliés aux propriétés physiques du spécimen observé. La microscopie tomographique diffractive pour des images en 3D Emil Wolf a proposé dès 1969 une approche pour dépasser ces limites : lorsqu’une onde plane monochromatique, comme produite par un laser, interagit avec un objet faiblement diffractant/absorbant, mesurer précisément et complètement l’onde résultante de l’interaction de l’illumination avec l’objet observé permet alors de calculer la distribution des indices optiques dans cet objet, c’est-à-dire calculer ses propriétés optiques (l’indice de réfraction et l’absorption), qui sont justement celles perdues dans les microscopes classiques. Cet article fondamental en imagerie optique est longtemps resté inexploité. On le comprend aisément avec les limitations techniques de l’époque : les lasers pour créer l’onde plane monochromatique illuminant le spécimen sont à peine développés, mais surtout, les capteurs numériques pour enregistrer les images n’existent pas, et les ordinateurs sont incapables, en quantité de mémoire comme en vitesse d’exécution, de traiter les données nécessaires au calcul des images en 3D. Après quelques premiers essais fructueux dans les années 1980-1990, le domaine a été relancé dans les années 2000, en grande partie via un article de Vincent Lauer, qui avait montré que des lasers abordables, des caméras performantes, et des ordinateurs courants enfin à même d’effectuer directement les reconstructions 3D, rendaient ce type d’imagerie abordable. La microscopie tomographique diffractive (aussi connue comme tomographie de phase, microscopie à synthèse d’ouverture, tomographie optique en diffraction…) a alors connu un regain d’intérêt spectaculaire, et est même maintenant disponible commercialement. Son principe général est relativement simple, et proche de celui des scanners (computerised tomography ou CT scan) en imagerie médicale : pour une illumination du spécimen, on enregistre l’amplitude et la phase de l’onde diffractée. Ceci se fait maintenant facilement par des techniques d’holographie numérique. L’hologramme enregistré contient une partie, mais une petite partie seulement, de l’information nécessaire pour recalculer en 3D l’objet observé. Il faut alors multiplier les mesures, puis les fusionner numériquement afin d’augmenter l’information 3D acquise et améliorer l’image finale. Pour varier l’information acquise par chaque hologramme, on change les conditions d’illumination, et on répète le processus. Avec un grand nombre d’illuminations, on accumule l’information pour obtenir un ensemble de mesures bien plus étendu et complet qu’en microscopie holographique avec une seule illumination. Cette étape est dite de synthèse d’ouverture, analogue à la synthèse d’ouverture utilisée en imagerie radar. Avec une caméra scientifique standard, l’acquisition des données dure d’une à quelques secondes selon la précision finale demandée (pour quelques dizaines à plusieurs centaines d’hologrammes). Au final, on obtient même deux images de l’objet, en réfraction (la capacité de cet objet à courber les rayons lumineux) et en absorption (la capacité de cet objet à absorber la lumière). Dans les microscopes optiques classiques, l’image obtenue est en fait un mélange de ces deux quantités. Les spécificités de ces images de microscopie tomographique diffractive sont une meilleure résolution, environ 100 nm,…