Stéphane Bazeille, Université de Haute-Alsace (UHA)

Les robots actuels disposent de très peu de capacités de perception. Volodimir Zozulinskyi/Shutterstock

Pour percevoir son environnement, il faut non seulement pouvoir le capter, mais aussi interpréter les données de façon judicieuse — ceci reste un défi pour les robots.

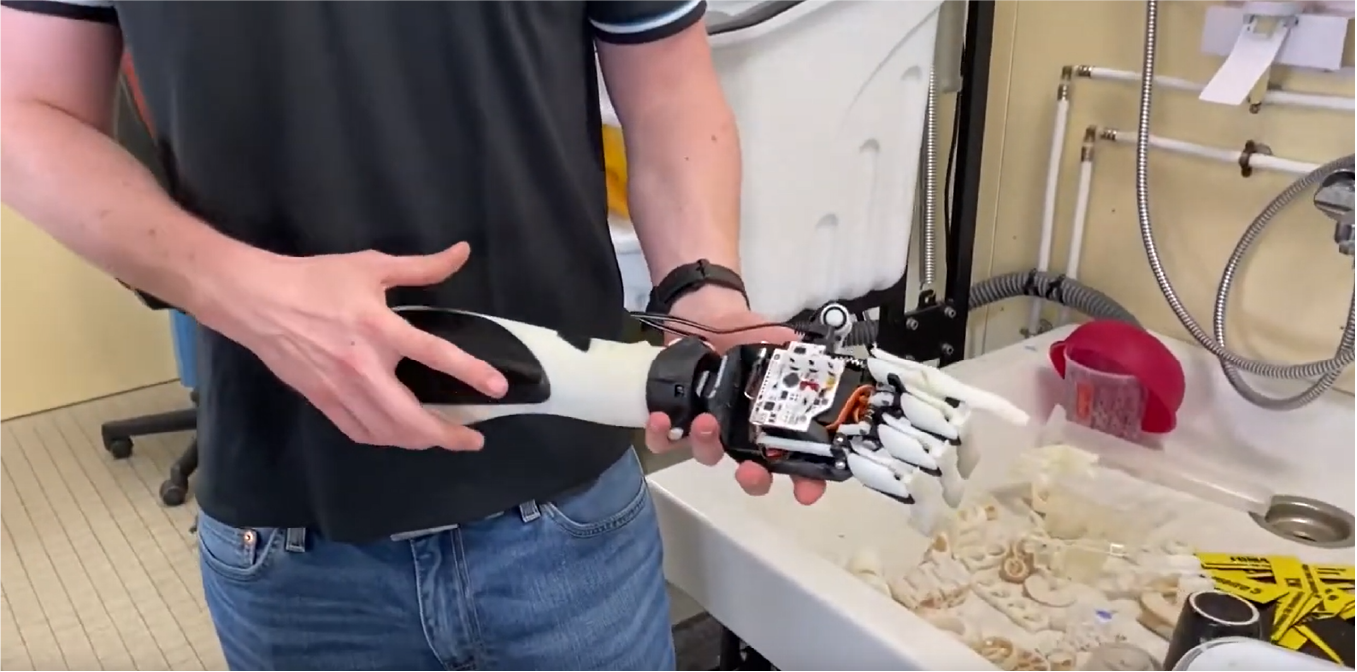

Les robots destinés au grand public sont de plus en plus présents dans notre quotidien, mais ils restent aujourd’hui assez proches de plates-formes à roues ou volantes (aspirateurs, tondeuses, drones par exemple). L’industrie est équipée de bras spécialisés, pour l’assemblage et la manutention. Ces robots industriels et du quotidien ont un point commun : ils disposent de peu de capteurs leur permettant de percevoir le monde. Ceci les rend plus simples à gérer, mais limite grandement leurs capacités.

On observe néanmoins depuis quelques années l’émergence de robots beaucoup plus complexes. Les robots humanoïdes, comme ceux de Boston Dynamics ou plus récemment Tesla, en sont les exemples les plus frappants. Ces robots plus perfectionnés restent aujourd’hui des robots de recherche : ils peuvent faire beaucoup plus de choses, mais leur programmation nécessite beaucoup plus de capteurs, comme c’est le cas d’Atlas, le robot de Boston Dynamics, sur cette vidéo.

Si leurs capacités mécaniques sont de plus en plus spectaculaires, la difficulté principale aujourd’hui est de donner aux robots des capacités de perception pour pouvoir interagir facilement avec leur environnement.

En effet, c’est bien notre perception de l’environnement qui nous permet, à nous, humains, de reconnaître et de localiser des objets pour les attraper, d’estimer leurs trajectoires pour anticiper leurs positions, de nous déplacer d’un point à un autre en évitant les obstacles par exemple.

La perception peut aujourd’hui être basée sur différents capteurs qui mesurent différentes grandeurs physiques telles que le flux lumineux, la distance, les accélérations ou les rotations.

Chez les humains, l’oreille interne perçoit la position et l’orientation de la tête et permet de se maintenir en équilibre, tandis que les drones ou les robots humanoïdes maintiennent leur équilibre en mesurant les accélérations et vitesses de rotation de leur corps, mesurées à très haute fréquence grâce à une centrale inertielle. Les aspirateurs quant à eux évitent les obstacles grâce à des capteurs de distance qui leur permettent de construire des cartes de leur environnement.

Toutes ces tâches (équilibre, localisation, analyse de l’environnement) sont primordiales pour améliorer l’autonomie des robots, mais équiper un robot d’un système de perception est un travail considérable : il faut acquérir les données, les traiter, et prendre une décision sur le comportement du robot en fonction de ces informations.

Des yeux au cerveau, des caméras à l’ordinateur embarqué

Chaque capteur restitue à l’ordinateur embarqué une information de plus ou moins « haut niveau », c’est-à-dire nécessitant plus ou moins de traitement par la suite pour en extraire du sens. Les capteurs les plus riches, mais aussi les plus complexes à utiliser, sont ceux développés pour la vision.

L’homme a un système visuel très développé et entraîné depuis la petite enfance pour reconnaître, localiser, mesurer, estimer les mouvements : notre œil fournit une image brute, mais notre cerveau sait l’interpréter.

De façon similaire, les données encodant les images des caméras traditionnelles sont de très « bas niveau » : une caméra enregistre simplement une liste ordonnée de pixels qui correspondent à la quantité de lumière reçue sur un petit élément de surface photosensible du capteur, auquel s’ajoute potentiellement une information sur la couleur (longueur d’onde) — comme notre œil.

Pour comparaison, une information de « haut niveau » simple et utilisable par un robot serait par exemple :

« Il y a un objet blanc sur la table et il est situé à une distance de 100 millimètres en x et 20 millimètres en y du coin de la table. »

Fournir ce type d’informations à un robot en temps réel est possible aujourd’hui avec les capacités de traitement des ordinateurs. Si on prend l’exemple des bras robotiques industriels, ils sont aujourd’hui vendus sans système de perception et ne peuvent attraper des objets qui si leurs positions et orientations ont été données au robot lors de la programmation. Pour être capable d’attraper des objets, quelle que soit la manière dont ils sont disposés, il faut donner la possibilité au robot de voir l’objet.

C’est possible aujourd’hui grâce à des caméras « intelligentes », c’est-à-dire qui embarquent un ordinateur et des librairies de traitement d’images pour transmettre aux robots des informations directement exploitables.

Ainsi équipé, le robot peut attraper un objet, mais, cette fois-ci, quelle que soit la manière dont il est disposé.

Permettre aux robots de voir en 3D

Un autre défi pour les robots est de se déplacer dans un environnement changeant. Dans une foule par exemple, les humains estiment en permanence leurs déplacements et construisent une carte des alentours pour déterminer les zones libres et les zones occupées afin d’estimer une trajectoire menant à leur destination.

Sur un robot, avec seulement une caméra monoculaire, faire de la localisation et cartographie simultanée est un problème très complexe. Et le résultat obtenu est un résultat approximatif car on a un problème d’« ambiguïté d’échelle », c’est-à-dire que les mouvements sont bien estimés, mais les distances sont justes à un facteur d’échelle près. Pour lever cette ambiguïté d’échelle, il faut du « multi-vues » — deux yeux dans notre cas, ou deux caméras.

Intégrer deux yeux sur un robot est délicat car avec deux capteurs, il y a deux fois plus d’informations à traiter, à synchroniser et à calibrer pour obtenir la position précise d’une caméra par rapport à autre.

Grâce à l’évolution des capteurs de vision, on peut aujourd’hui voir en 3D avec une seule caméra light-field. Ces caméras sont un peu spéciales : en utilisant une matrice de micro-objectifs située entre le capteur et l’objectif, elles captent l’intensité lumineuse d’une scène comme sur un appareil classique, mais aussi la direction d’arrivée des rayons lumineux. Ceci permet en particulier de retrouver la profondeur, donc la 3D, avec une seule image.

Un petit robot équipé de ce type de caméra par exemple peut obtenir une localisation et une carte métrique cohérente avec la réalité (en levant l’ambiguïté d’échelle). C’est le travail que nous effectuons aujourd’hui au laboratoire IRIMAS, notamment dans le cadre d’une thèse.![]()

Stéphane Bazeille, Enseignant chercheur en robotique, Université de Haute-Alsace (UHA)

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.